由于最近KubeSphere的事件,离线部署私有化现在变的很有必要。这里基于3.1.10版本KubeKey,在此基础上二开为kt工具。

本文暂时演示使用kt离线部署k8s 1.32.7+ks4.1.3,若有其他需要可添加我微信好友sd_zdhr。

ks4免费许可与ks3.*版本不同,商业用途时注意查看ks4的license。

1.说明

关于kt

kt是基于kk二次开发的产物,具备kk的所有功能。二开主要为适配信创国产化环境、简化arm部署过程和国产化环境离线部署。支持arm64和amd64架构国产操作系统,已适配芯片+操作系统 如上。

kt****新增功能点

- 更新基础组件版本

- 适配arm架构harbor和支持,部署体验与X86一样简单。

- 离线环境部署增强。常用国际和国产操作系统依赖,内置到安装包中。已适配芯片和操作系统如下

- CPU:鲲鹏、飞腾、海光、兆芯、intel、amd等。

- OS:Centos、Ubuntu、Debian、银河麒麟V10、麒麟国防版、麒麟信安、中标麒麟V7、统信UOS、华为欧拉、移动大云、阿里龙蜥等。

./kt init-os一条命令完成操作系统依赖安装和初始化操作。

- 支持开启防火墙,只暴露

30000-32767端口,其他k8s端口添加到节点白名单。./kt firewall一条命令自动获取节点信息开白名单和防火墙。

基础组件版本信息

- KubeKey: v3.1.10.1(二开版)

- Containerd: v2.0.6

- Crictl: v1.33.0

- Docker: v28.2.2

- Etcd: v3.5.22

- Harbor: v2.13.2

- Docker-compose: v2.29.1

- Kubernetes:v1.32.7

离线制品地址

- 制品:

**[全量离线包](**``**https://pan.quark.cn/s/a0999bd891e0**``**。 "离线制品")** - kt:

**[kt_**.tar.gz](**``**https://pan.xunlei.com/s/VOWYIm73QisshzT4vAfFR-3LA1?pwd=c9nt#**``**。 "kt压缩包")** - 关注我不迷路

2.环境准备

服务器基本信息

| 主机名 | 架构 | OS | 配置 | IP |

|---|---|---|---|---|

| node1 | arm64 | openEuler 22.03 | 8核16G | 192.168.0.121 |

将对应架构[kt_**.tar.gz](``https://pan.xunlei.com/s/VOWYIm73QisshzT4vAfFR-3LA1?pwd=c9nt#``。 "kt压缩包")上传至每个节点

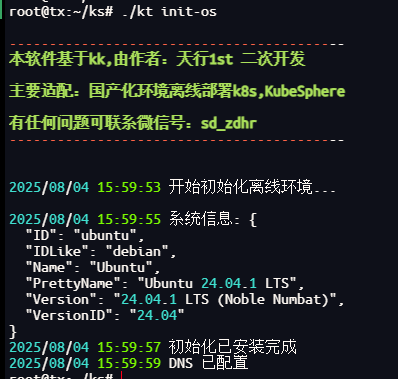

2.1 系统初始化

操作系统不需要安装docker等,全新的操作系统即可。解压kt文件后执行./kt init-os 已适配操作系统和架构见1.说明

该命令kt会自动判断操作系统和架构以安装依赖项和进行必要的初始化配置。

3.构建离线包

将[kt_x86.tar.gz](``[https://pan.quark.cn/s/43079afd65de](https://pan.quark.cn/s/43079afd65de)``。 "kt_x86版本")上传至可联网节点上操作

3.1 创建 manifest 文件

export KKZONE=cn

./kt create manifest --with-kubernetes v1.32.7 --arch arm64 --with-registry

3.2 编辑 manifest 文件

vi manifest-sample.yaml

apiVersion: kubekey.kubesphere.io/v1alpha2

kind: Manifest

metadata:

name: sample

spec:

arches:

- arm64

operatingSystems: []

kubernetesDistributions:

- type: kubernetes

version: v1.32.7

components:

helm:

version: v3.14.3

cni:

version: v1.7.1

etcd:

version: v3.5.22

containerRuntimes:

- type: docker

version: 28.2.2

- type: containerd

version: 2.0.6

calicoctl:

version: v3.30.2

crictl:

version: v1.33.0

docker-registry:

version: "2"

harbor:

version: v2.13.2

docker-compose:

version: v2.29.1

images:

- registry.cn-beijing.aliyuncs.com/kubesphereio/pause:3.9

- registry.cn-beijing.aliyuncs.com/kubesphereio/kube-apiserver:v1.32.7

- registry.cn-beijing.aliyuncs.com/kubesphereio/kube-controller-manager:v1.32.7

- registry.cn-beijing.aliyuncs.com/kubesphereio/kube-scheduler:v1.32.7

- registry.cn-beijing.aliyuncs.com/kubesphereio/kube-proxy:v1.32.7

- registry.cn-beijing.aliyuncs.com/kubesphereio/coredns:1.9.3

- registry.cn-beijing.aliyuncs.com/kubesphereio/k8s-dns-node-cache:1.22.20

- dockerhub.kubekey.local/kubesphereio/kube-controllers:v3.30.2

- dockerhub.kubekey.local/kubesphereio/cni:v3.30.2

- dockerhub.kubekey.local/kubesphereio/node:v3.30.2

- dockerhub.kubekey.local/kubesphereio/pod2daemon-flexvol:v3.30.2

- dockerhub.kubekey.local/kubesphereio/typha:v3.30.2

- registry.cn-beijing.aliyuncs.com/kubesphereio/flannel:v0.21.3

- registry.cn-beijing.aliyuncs.com/kubesphereio/flannel-cni-plugin:v1.1.2

- registry.cn-beijing.aliyuncs.com/kubesphereio/cilium:v1.15.3

- registry.cn-beijing.aliyuncs.com/kubesphereio/operator-generic:v1.15.3

- dockerhub.kubekey.local/kubesphereio/hybridnet:v0.8.6

- registry.cn-beijing.aliyuncs.com/kubesphereio/kube-ovn:v1.10.10

- registry.cn-beijing.aliyuncs.com/kubesphereio/multus-cni:v3.8

- registry.cn-beijing.aliyuncs.com/kubesphereio/provisioner-localpv:3.3.0

- registry.cn-beijing.aliyuncs.com/kubesphereio/linux-utils:3.3.0

- registry.cn-beijing.aliyuncs.com/kubesphereio/haproxy:2.9.6-alpine

- registry.cn-beijing.aliyuncs.com/kubesphereio/kube-vip:v0.7.2

- registry.cn-beijing.aliyuncs.com/kubesphereio/kata-deploy:stable

- registry.cn-beijing.aliyuncs.com/kubesphereio/node-feature-discovery:v0.10.0

## ks-core

- swr.cn-south-1.myhuaweicloud.com/gjing1st/kubesphere/ks-extensions-museum:v1.1.6

- swr.cn-south-1.myhuaweicloud.com/gjing1st/kubesphere/ks-controller-manager:v4.1.3

- swr.cn-south-1.myhuaweicloud.com/gjing1st/kubesphere/ks-apiserver:v4.1.3

- swr.cn-south-1.myhuaweicloud.com/gjing1st/kubesphere/ks-console:v4.1.3

- swr.cn-south-1.myhuaweicloud.com/gjing1st/kubesphere/kubectl:v1.27.16

- swr.cn-south-1.myhuaweicloud.com/gjing1st/kubesphere/redis:7.2.4-alpine

- swr.cn-south-1.myhuaweicloud.com/gjing1st/kubesphere/haproxy:2.9.6-alpine

registry:

auths: {}

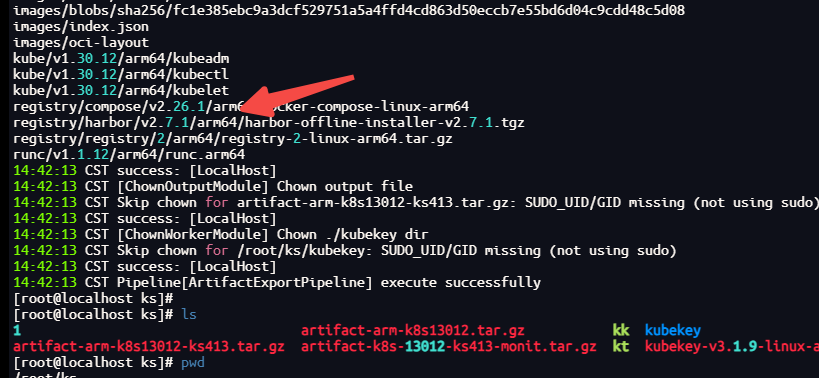

3.3 导出离线制品

./kt artifact export -m manifest-sample.yaml -o artifact-arm-k8s1327-ks413.tar.gz

可以看到下载了arm64 版本的harbor,由于harbor官方不支持arm版本,因此kk也不支持arm版本harbor。此版本harbor和kk为自己制作,由于harbor:v2.8.0版本之后不支持扩展helm功能,我司需要用其helm管理应用,所以这里使用v2.7.1版本。

3.4 下载 KubeSphere Core Helm Chart

安装helm

curl https://raw.githubusercontent.com/helm/helm/main/scripts/get-helm-3 | bash

下载 KubeSphere Core Helm Chart

VERSION=1.1.5 # Chart 版本

helm fetch https://charts.kubesphere.io/main/ks-core-${VERSION}.tgz

4 创建 Harbor私有仓库

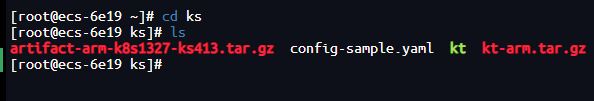

3.1 上传kt

将kt和离线制品上传至服务器

3.2 创建集群配置文件

主要修改相关节点和harbor信息

./kt create config --with-kubernetes v1.32.7

3.3 修改配置文件

根据实际服务器信息,配置到生成的config-sample.yaml中

kind: Cluster

metadata:

name: sample

spec:

hosts:

- {name: node1, address: 192.168.0.121, internalAddress: 192.168.0.121, user: root, password: "123456",arch: "arm64"}

roleGroups:

etcd:

- node1

control-plane:

- node1

worker:

- node1

# 如需使用 kk 自动部署镜像仓库,请设置该主机组 (建议仓库与集群分离部署,减少相互影响)

# 如果需要部署 harbor 并且 containerManager 为 containerd 时,由于部署 harbor 依赖 docker,建议单独节点部署 harbor

registry:

- node1

controlPlaneEndpoint:

## Internal loadbalancer for apiservers

# internalLoadbalancer: haproxy

domain: lb.kubesphere.local

address: ""

port: 6443

kubernetes:

version: v1.32.7

clusterName: cluster.local

autoRenewCerts: true

containerManager: docker

etcd:

type: kubekey

network:

plugin: flannel

kubePodsCIDR: 10.233.64.0/18

kubeServiceCIDR: 10.233.0.0/18

## multus support. https://github.com/k8snetworkplumbingwg/multus-cni

multusCNI:

enabled: false

registry:

type: harbor

registryMirrors: []

insecureRegistries: []

privateRegistry: "dockerhub.kubekey.local"

namespaceOverride: "kubesphereio"

auths: # if docker add by `docker login`, if containerd append to `/etc/containerd/config.toml`

"dockerhub.kubekey.local":

username: "admin"

password: Harbor@123 # 此处可自定义,kk3.1.8新特性

skipTLSVerify: true # Allow contacting registries over HTTPS with failed TLS verification.

plainHTTP: false # Allow contacting registries over HTTP.

certsPath: "/etc/docker/certs.d/dockerhub.kubekey.local"

addons: []

说明: 这里写一下注意事项

config-sample.yaml 配置文件的 spec:hosts 参数

官方介绍

- address 服务器的 SSH 登录 IP 地址。

- internalAddress 服务器在子网内部的 IP 地址。

注:若部署的服务器在同一区域,内网IP可以互通,address 和internalAddress 都使用内网IP。之前遇到过有的小伙伴买的云服务器做测试,address使用公网IP,由于部署过程通信拷贝文件走了address,公网带宽又低。导致创建集群时异常的慢。

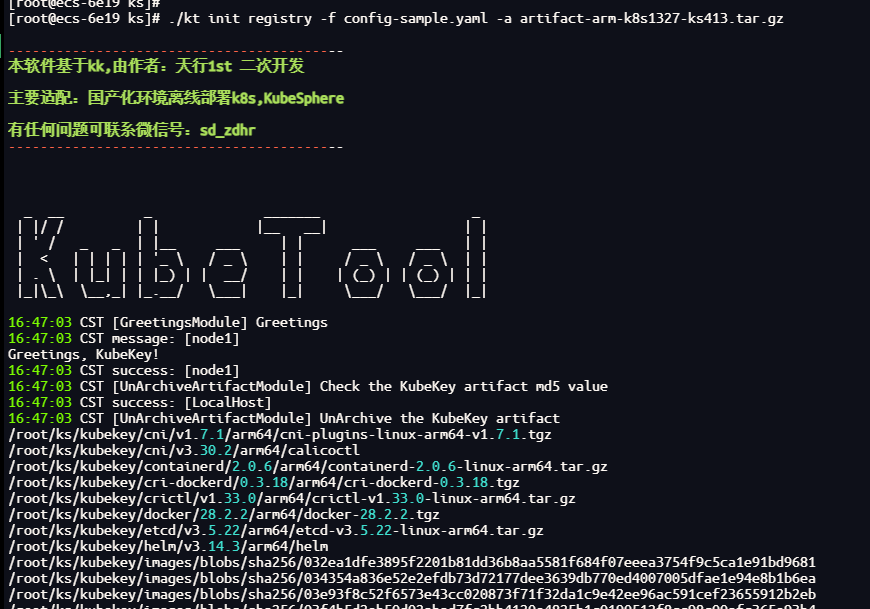

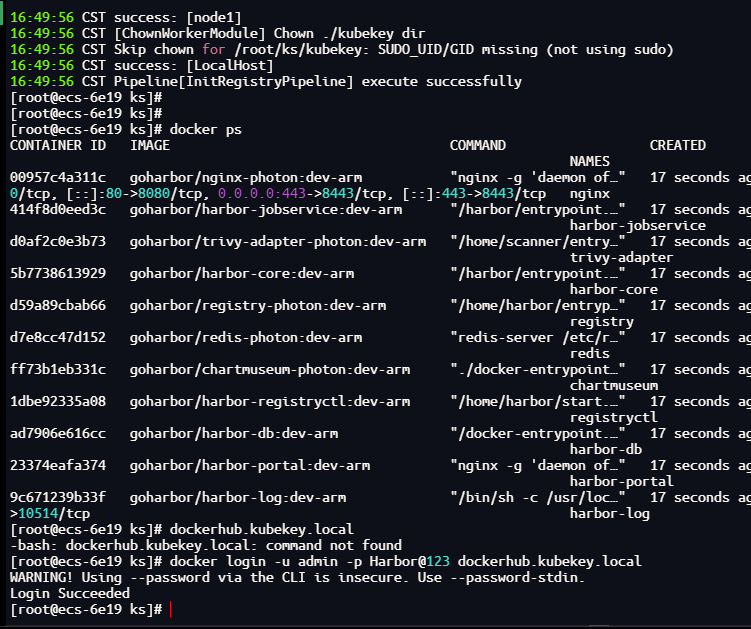

3.4 创建镜像仓库

./kt init registry -f config-sample.yaml -a artifact-arm-k8s1327-ks413.tar.gz

此命令会自动安装docker和docker-compose

验证登录

docker login -u admin -p Harbor@123 dockerhub.kubekey.local

3.5 创建harbor项目

说明:

Harbor 管理员账号:admin,密码:Harbor@123。密码同步使用配置文件中的对应password

harbor 安装文件在 <font style="background-color:rgb(255,245,235);">/opt/harbor</font> 目录下,可在该目录下对 harbor 进行运维。

vi create_project_harbor.sh

#!/usr/bin/env bash

url="https://dockerhub.kubekey.local" # 或修改为实际镜像仓库地址

user="admin"

passwd="Harbor@123"

harbor_projects=(

ks

kubesphere

kubesphereio

tx1st

gjing1st

)

for project in "${harbor_projects[@]}"; do

echo "creating $project"

curl -u "${user}:${passwd}" -X POST -H "Content-Type: application/json" "${url}/api/v2.0/projects" -d "{ \"project_name\": \"${project}\", \"public\": true}" -k # 注意在 curl 命令末尾加上 -k

done

创建 Harbor 项目

chmod +x create_project_harbor.sh

./create_project_harbor.sh

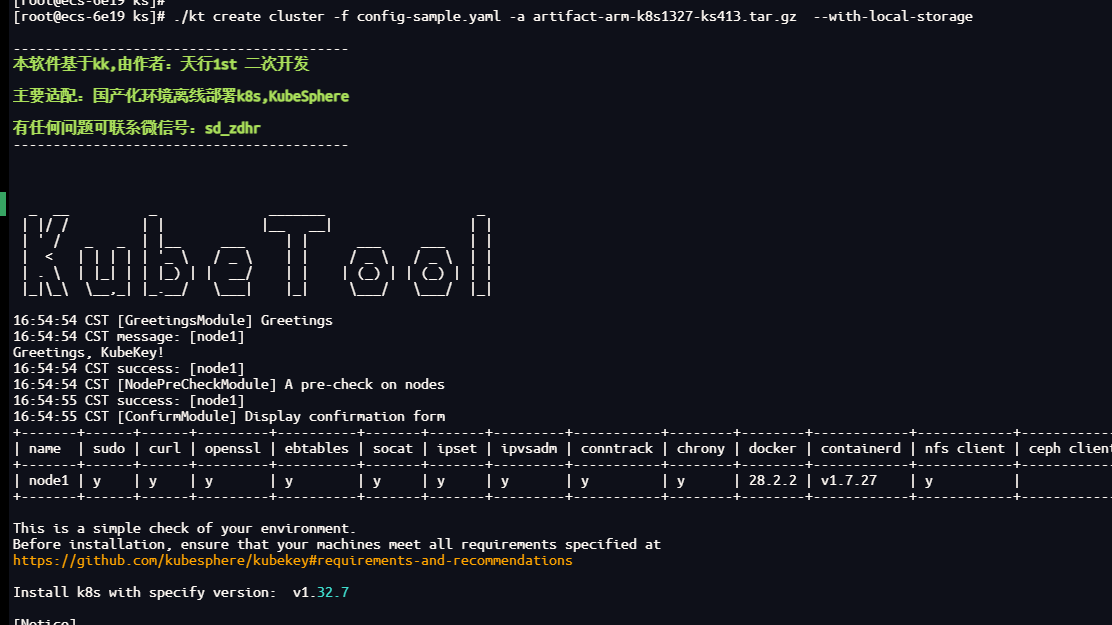

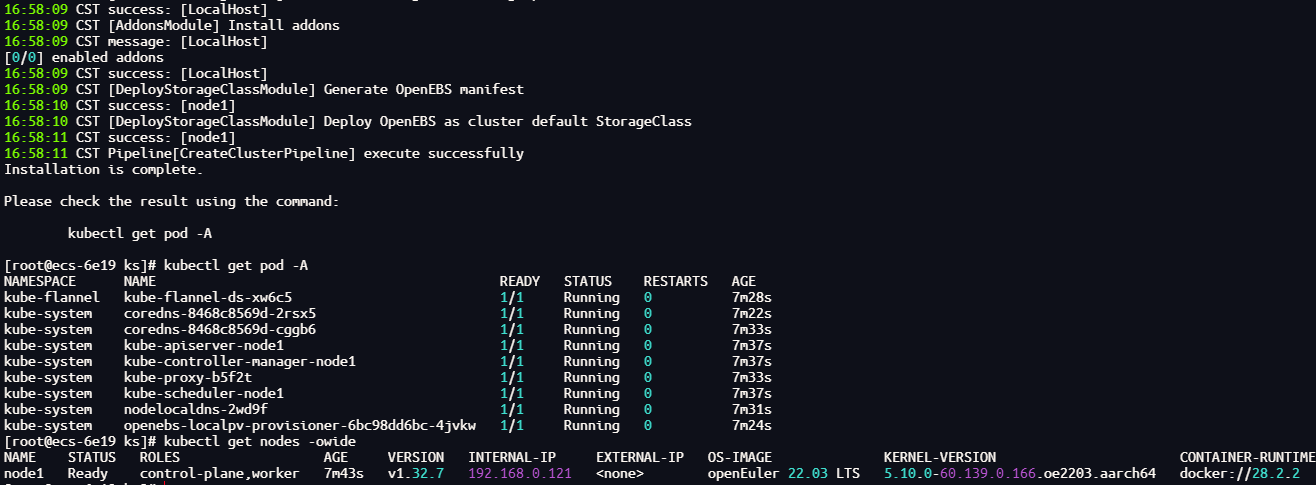

4 创建k8s集群

执行以下命令创建 Kubernetes 集群:

./kt create cluster -f config-sample.yaml -a artifact-k8s1333-ks413.tar.gz --with-local-storage

此命令kt会自动将离线制品中的镜像推送到harbor 私有仓库

执行后会有如下提示,输入y继续执行

等待一段时间可以看到成功的消息

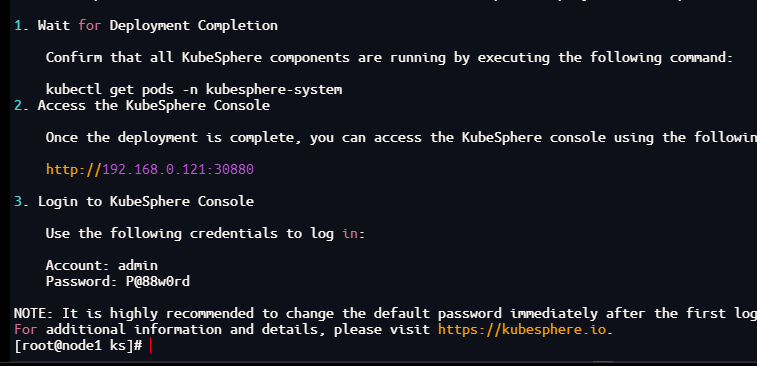

5 安装 KubeSphere

helm upgrade --install -n kubesphere-system --create-namespace ks-core ks-core-1.1.5.tgz \

--set global.imageRegistry=dockerhub.kubekey.local/gjing1st \

--set extension.imageRegistry=dockerhub.kubekey.local/gjing1st \

--set ksExtensionRepository.image.tag=v1.1.6 \

--set ha.enabled=true \

--set redisHA.enabled=true \

--debug \

--wait

等待大概1分钟左右看到成功消息

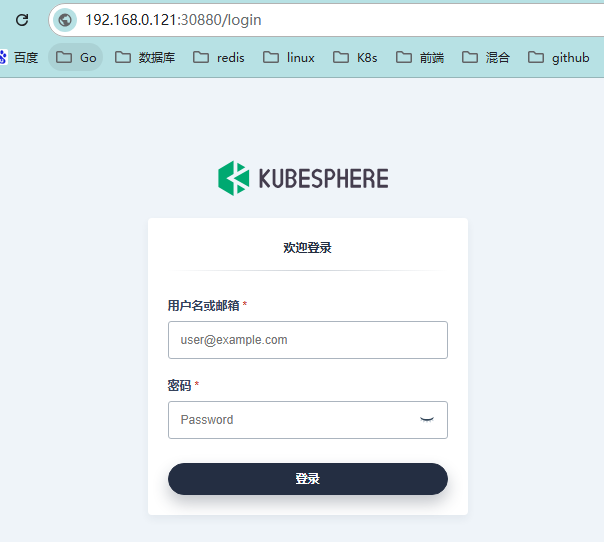

6 验证

登录页面

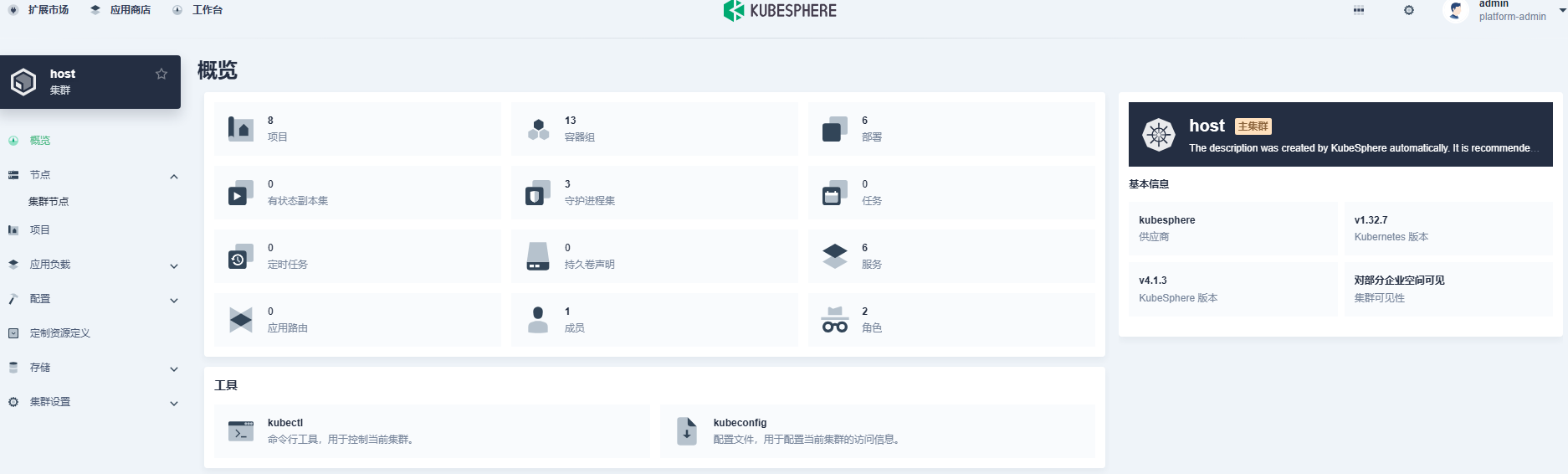

首页

集群管理

概览

节点信息

加入交流群,一起探讨后续使用。

评论区